GLM-4.7, най-новият голям езиков модел с отворен код от Zhipu AI, беше официално пуснат, носейки значителни надстройки в кодирането, разсъжденията и агентното изпълнение. Изданието укрепва позицията на GLM като един от най-способните модели с отворен код за разработка на софтуер в реалния свят и работни процеси, управлявани от инструменти.

По-силни възможности за кодиране и агент

GLM-4.7 въвежда значими подобрения в производителността на програмирането, особено в многоезичното кодиране и работните потоци на агенти, базирани на терминали. Сега моделът поддържа надежден механизъм „помисли преди да действаш“ в популярни рамки за кодиране като Claude Code, TRAE, Kilo Code, Cline и Roo Code, което води до по-голяма стабилност при сложни, многоетапни задачи.

Ключовите подобрения включват:

- Усъвършенствана производителност на кодиране: По-стабилно генериране и изпълнение на код в различни езици и среди.

- Подобрена естетика на предния край: По-висококачествено генериране на уеб страници, слайдове и плакати, с по-добро оформление, визуален баланс и кохерентност на дизайна.

- По-силно използване на инструмента: GLM-4.7 отбелязва 67,5 на теста за уеб задачи BrowseComp и постига 87,4 на τ²-Bench за използване на интерактивни инструменти – поставяйки ново ниво на изкуството с отворен код и надминавайки Claude Sonnet 4.5.

- Подобрено разсъждение: В бенчмарка HLE („Последният изпит на човечеството“), GLM-4.7 достига 42,8%, подобрение с 41% спрямо GLM-4.6 и превъзхожда GPT-5.1.

- По-естествена обща интелигентност: Разговорите са по-сбити и подобни на човешки, със забележимо подобрение в качеството на писане и потапяне в ролевата игра.

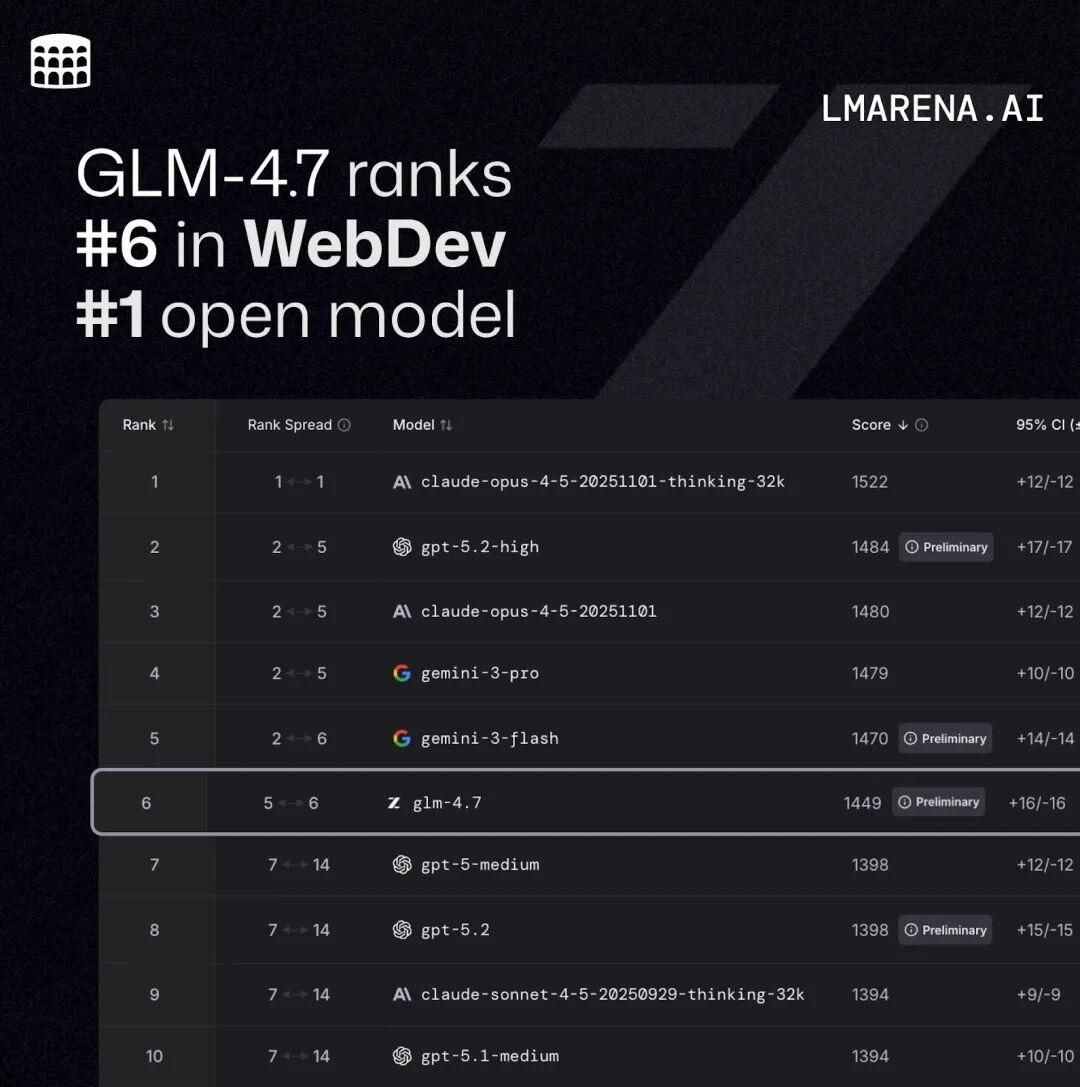

В Code Arena, платформа за оценка на сляпо кодиране с над един милион участници по целия свят, GLM-4.7 се нарежда на първо място сред моделите с отворен код и на първо място сред китайските модели, надминавайки GPT-5.2.

Резултати от бенчмарк: Конкурентни с водещи затворени модели

В основните стандарти GLM-4.7 се приравнява тясно към Claude Sonnet 4.5 по отношение на производителността на кодирането:

- SWE-bench-Verified: 73,8% (SOTA с отворен код)

- LiveCodeBench v6: 84,9% (SOTA с отворен код, надхвърлящ Claude Sonnet 4.5)

- SWE-bench Multilingual: 66,7% (+12,9%)

- Терминална пейка 2.0: 41% (+16,5%)

Осезаеми печалби в развитието на реалния свят

1.1 Реални задачи по програмиране

В тестове, включващи 100 задачи за кодиране в реалния свят в рамките на средата на Claude Code – покриващи преден край, бек-енд и следване на инструкции – GLM-4.7 демонстрира ясни предимства спрямо GLM-4.6 както по отношение на стабилността, така и по отношение на доставянето. Разработчиците вече могат да организират работни потоци около пълното изпълнение на задачите, от разбирането на изискванията до готовия за производство резултат.

1.2 Еволюция на контролируемото разсъждение

GLM-4.7 разширява своята система за разсъждение с три режима:

- Преплетено мислене: Моделът разсъждава преди всеки отговор или извикване на инструмент, подобрявайки придържането към инструкциите и качеството на кода.

- Запазено мислене: Разсъждаващите блокове продължават да съществуват в разговори с няколко хода, повишавайки ефективността на кеша и намалявайки разходите за дългосрочни задачи.

- Контрол на мисленето на ниво ход: Разработчиците могат да превключват дълбочината на разсъждение на ход – като го деактивират за прости заявки, за да намалят забавянето, или го активират за сложни задачи, за да подобрят точността.

1.3 Изпълнение на комплексна задача

Моделът показва по-силна декомпозиция на задачите и интеграция на технологичен стек, като често произвежда завършени, изпълняваеми проекти с едно преминаване, с ясни инструкции за зависимост и изпълнение. Демонстрациите включват напълно генерирани интерактивни игри като заглавия в стил Plants vs. Zombies и преживявания, подобни на Fruit Ninja.

1.4 Преден дизайн и визуален изход

GLM-4.7 показва по-задълбочено разбиране на визуалния код и конвенциите на потребителския интерфейс. Изходите по подразбиране се отличават с подобрена структура на оформлението, хармония на цветовете и стилизиране на компонентите – намалявайки необходимостта от ръчна визуална фина настройка. В сценариите за продуктивност в офиса, точността на оформлението PPT 16:9 скочи от 52% на 91%, което прави резултатите до голяма степен „отворени и използвани“.

GLM план за кодиране Актуализиран с GLM-4.7

Планът за кодиране на GLM е надграден, за да включва GLM-4.7, предлагайки оптимизиран баланс между производителност, скорост и цена:

- Пълна поддръжка на разсъждения в Claude Code за стабилно многоетапно изпълнение

- Целеви оптимизации за умения, субагенти и работни процеси на Claude.md

- Вградено визуално разбиране, търсене и четене в мрежата за кодиране от край до край

- По-силен архитектурен дизайн и следване на инструкции, намаляване на халюцинациите в сценарии с дълъг контекст Като част от стартирането, всички платени потребители получават пропуск за опит, позволяващ на 3–7 поканени потребители да имат достъп до 7-дневен безплатен пробен период.

Широко приемане от разработчици и екосистемна поддръжка

Глобални платформи за разработчици отчетоха силни резултати:

- TRAE подчерта подобрената стабилност и наличност на GLM-4.7 в неговото китайско издание.

- Cerebras отбеляза, че GLM-4.6 е постигнал до 1000 жетона в секунда на своя хардуер, предоставяйки едно от най-бързите налични изживявания при кодиране.

- YouWare отчете значителни подобрения в качеството на дизайна на предния край, завършването на сложни функции, паралелността на инструментите и спазването на инструкциите. Допълнителни положителни отзиви идват от Vercel, OpenRouter, CodeBuddy и независими разработчици.

Пълна интеграция на стека на z.ai и отворен достъп

GLM-4.7 вече е интегриран в z.ai с нов модул за умения, позволяващ унифицирана оркестрация на мултимодални компоненти като GLM-4.6V, GLM-ASR и GLM-TTS. Това позволява на разработчиците да създават по-богати, по-интерактивни приложения с по-плавни работни процеси от край до край. Опциите за достъп включват:

- API: BigModel.cn

- Онлайн: z.ai, Zhipu Qingyan (приложение и уеб)

- Отворен код:

- GitHub: zai-org/GLM-4.5

- Прегръщащо лице: zai-org/GLM-4.7

- Обхват на модела: ZhipuAI/GLM-4.7

Източник https://bccci.net/bg/feed/